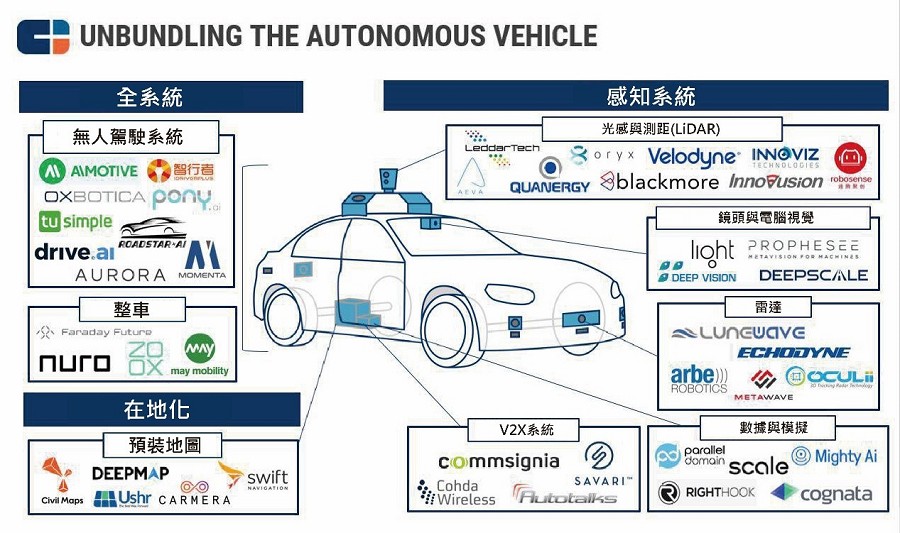

深入探討先進感知系統:多模態感測器融合

在自動化、機器人技術、智慧交通、工業 4.0 乃至更廣泛的 Physical AI 應用中,精準地理解周遭環境是實現自主化和智慧化的基石。這正是先進感知系統的核心任務。它不僅僅是單一感測器的數據收集,更是透過整合多模態感測器數據(如視覺、雷達、慣性測量單元 IMU 等),來實現對複雜環境的精準感知與環境建模。

透過整合不同感測器,系統能獲得更全面、魯棒的環境資訊。

為何需要多模態感測器融合?

單一感測器往往有其固有的局限性。例如:

- 視覺(攝影機): 能提供豐富的紋理、顏色和語義資訊,但容易受光照、惡劣天氣(霧、雨、雪)影響,且難以直接測量深度資訊。

- 雷達(Radar): 不受光照和惡劣天氣影響,能精確測量距離和速度,但解析度相對較低,難以識別物體的精確形狀和類別。

- 光達(LiDAR): 能提供高精度的三維點雲數據,直接測量深度,但容易受雨雪影響,且成本相對較高。

- 慣性測量單元 (IMU): 測量自身的角速度和加速度,用於精確的運動姿態估計,但存在累積誤差。

- 超音波感測器: 成本低,適合近距離障礙物檢測,但測量範圍有限且易受干擾。

多模態感測器融合的目標,就是結合不同感測器的優勢,彌補彼此的不足,從而獲得比任何單一感測器都更為全面、精確、魯棒且冗餘的環境感知能力。

多模態感測器融合的實現方式

感測器數據融合通常分為幾個層次:

- 低層次融合 (Early Fusion): 直接在原始感測器數據層進行融合。例如,將不同感測器的原始數據輸入到同一個深度學習模型中進行處理,讓模型自行學習數據之間的關聯性。

- 中層次融合 (Mid-Level Fusion): 在感測器提取出基本特徵後進行融合。例如,從攝影機圖像中提取物件邊緣資訊,從光達數據中提取平面資訊,然後將這些特徵進行融合。

- 高層次融合 (Late Fusion): 在每個感測器獨立完成對環境的「理解」或「決策」後,再將這些結果進行融合。例如,攝影機識別出行人,雷達檢測到一個移動物體,然後透過融合演算法判斷這是否是同一個行人,並做出最終的判斷。

從數據採集到融合處理,最終建立精準的環境模型。

精準感知與環境建模的關鍵技術

透過多模態感測器融合,先進感知系統能夠實現以下目標:

- 精確定位與地圖構建 (SLAM): 結合 IMU、視覺、光達等數據,系統能夠在未知環境中精確地確定自身位置,並同時構建高精度的環境地圖,這對於自主導航至關重要。

- 動態物件追蹤與行為預測: 透過融合視覺對物體類別的識別能力和雷達對速度、距離的精確測量,系統能穩定追蹤多個移動目標,並結合 AI 預測它們的未來行為軌跡(例如車輛變道、行人突然轉向)。

- 全天候與惡劣環境適應性: 雷達和熱像儀等感測器在夜間、濃霧、大雨等極端條件下表現優異,與視覺數據融合後,可顯著提升系統在各種天氣和光照條件下的感知魯棒性。

- 語義理解與情境感知: AI 結合多模態數據不僅能識別「這是輛車」,更能理解「這輛車正在高速駛來,可能需要避讓」,從而為決策提供更豐富的語義資訊。

- 冗餘性與安全性: 當某個感測器失效或數據異常時,其他感測器仍能提供可靠資訊,提高系統的容錯能力和安全性。

未來展望與挑戰

先進感知系統是實現完全自主化的關鍵。隨著感測器技術的進步(如更高解析度的光達、4D 成像雷達)和 AI 演算法的成熟(如基於Transformer 的多模態融合模型),其能力將持續提升。然而,挑戰依然存在,包括:

- 數據同步與時間戳校準: 不同感測器數據之間的時間同步是融合的難點。

- 感測器標定與校準: 精確的感測器內參和外參標定至關重要。

- 計算資源消耗: 處理和融合多模態大數據需要強大的邊緣計算能力。

- 未知與極端情境的魯棒性: 如何讓系統在面對從未見過或極端危險的情境時,依然能做出可靠判斷,是未來研究的重點。

先進感知系統實戰課程:循序漸進的學習路徑

本課程旨在引導學員從基礎感測器知識入門,逐步深入到多模態感測器融合的進階理論與實踐,最終能夠設計並實作具備先進感知能力的系統。

第一階段:感知系統基礎 (入門級)

建立對不同類型感測器的基本認識,理解其工作原理與數據特性。

- 課程目標: 熟悉常見感知感測器,了解其優缺點及應用場景。

- 內容概述:

- 感測器概論: 攝影機 (RGB/深度)、雷達 (毫米波雷達)、光達 (LiDAR)、慣性測量單元 (IMU)、超音波感測器。

- 數據特性與挑戰: 各感測器數據的格式、噪聲、限制與適用性分析。

- 基礎數據處理: 數據讀取、視覺化工具 (如 OpenCV、PCL 基礎)。

- 實作練習: 讀取並顯示攝影機影像、解析雷達/LiDAR 點雲數據。

- 建議工具: Raspberry Pi 或 Arduino (基礎實驗)、Python、OpenCV、Matplotlib。

第二階段:感測器數據預處理與校準 (進階)

學習如何準備感測器數據以供融合,確保數據的準確性與一致性。

- 課程目標: 掌握感測器數據的時間與空間校準方法,理解數據預處理的重要性。

- 內容概述:

- 時間同步: 介紹 NTP、PTP 等時間同步協議,及其在多感測器系統中的應用。

- 空間校準 (標定):

- 內參校準: 攝影機畸變校正、雷達/LiDAR 自身參數校準。

- 外參校準: 攝影機與攝影機、攝影機與雷達、攝影機與LiDAR、IMU 與其他感測器之間的坐標系轉換與標定。

- 工具與方法: 基於棋盤格的攝影機標定、手眼標定、自動化標定方法。

- 數據預處理技術: 噪聲濾波、數據去畸變、坐標系轉換。

- 實作練習: 執行攝影機內參標定、攝影機-LiDAR 外參標定。

- 建議工具: ROS (Robot Operating System)、Python/C++、OpenCV、PCL、Kalibr。

第三階段:多模態感測器融合理論與實踐 (專業級)

深入學習多模態數據融合的演算法和框架,並應用於實際問題。

- 課程目標: 掌握低、中、高層次數據融合演算法,能夠設計並實現融合系統。

- 內容概述:

- 融合層次與策略: 低層次 (Early Fusion)、中層次 (Mid-Level Fusion)、高層次 (Late Fusion) 融合的理論與應用場景。

- 濾波器與狀態估計: 擴展卡爾曼濾波 (EKF)、無跡卡爾曼濾波 (UKF)、粒子濾波 (PF) 及其在定位與追蹤中的應用。

- 基於優化的融合: 圖優化 (Graph Optimization) 與非線性最小二乘方法。

- 深度學習融合: 多模態深度學習網絡架構 (如 Transformer-based Fusion)、多感測器數據的特徵提取與融合網絡設計。

- 應用案例分析: SLAM 中的多感測器融合、動態目標追蹤、環境語義分割與識別。

- 實作練習: 基於 ROS 的攝影機-IMU 融合定位、使用深度學習框架進行多模態物件偵測。

- 建議工具: ROS (進階使用)、Python/C++、TensorFlow/PyTorch、PCL、GTSAM 或 Ceres Solver。

第四階段:系統整合與進階應用 (專家級)

將所學知識應用於複雜的自主系統,並探索前沿技術與挑戰。

- 課程目標: 具備獨立設計、開發和調試大型感知系統的能力,理解產業最新趨勢。

- 內容概述:

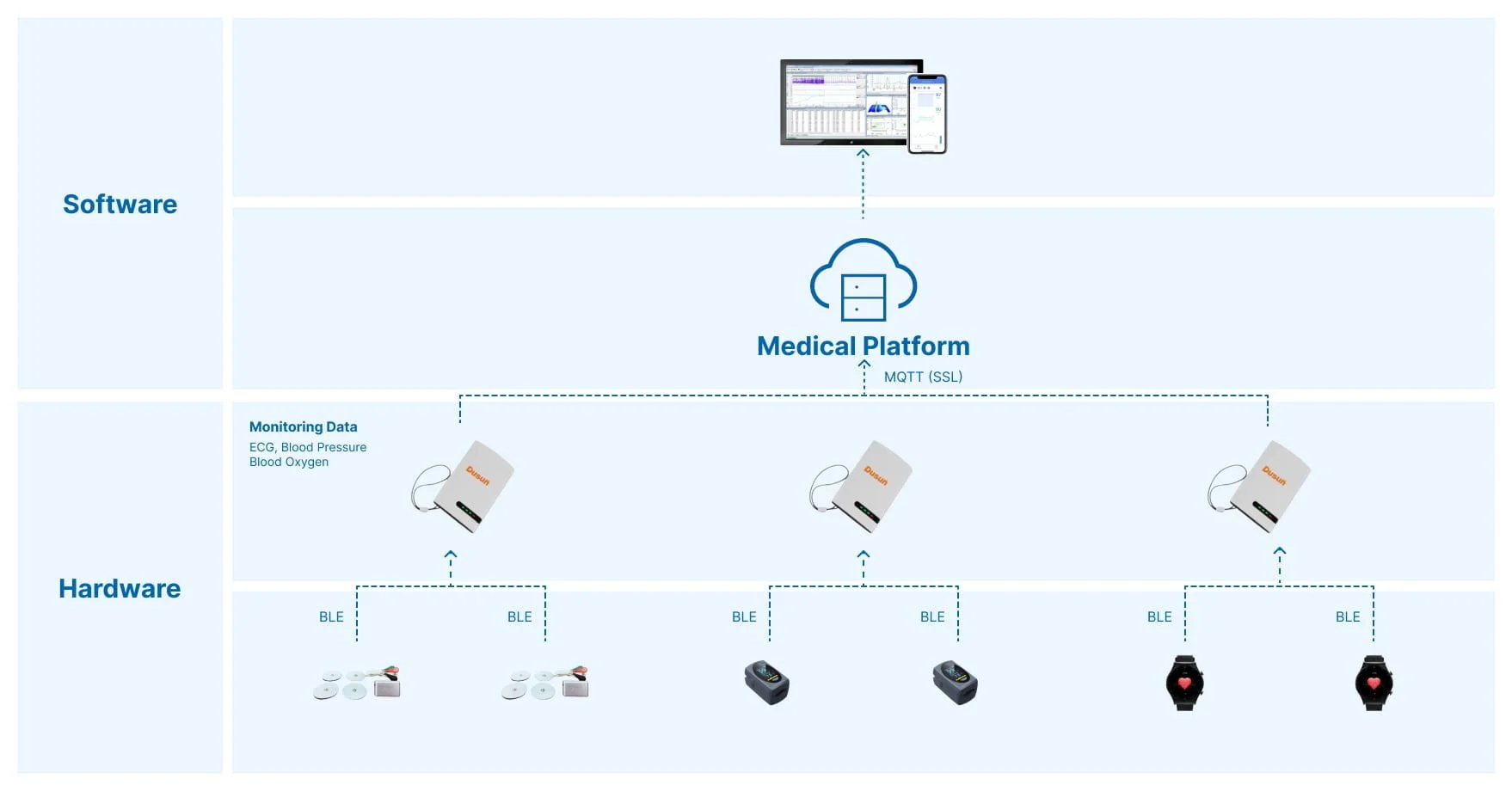

- 系統架構設計: 邊緣計算與雲端協同感知、異構感測器數據流管理。

- 性能評估與調試: 融合系統的精度、魯棒性、即時性評估指標與方法。

- 異常檢測與故障容錯: 數據異常處理、感測器失效檢測與應對策略。

- 最新研究與趨勢: 4D 雷達、事件相機、神經輻射場 (NeRF) 在感知中的應用。

- 實作專案: 開發一個結合攝影機、LiDAR 和 IMU 的小型自主導航系統,或實作具備特定環境感知能力的應用。

- 建議工具: 各種感測器硬體、自主系統開發平台 (如自動駕駛開發套件)、效能分析工具。